Jak jsme již informovali v této novince, v pátek 1.června se v sídle sdružení CZ.NIC uskutečnilo setkání v jehož rámci došlo k předání zkušenosti s provozováním národního CSIRT týmu zástupcům týmu CERT-RO (ten je stejně jako my akreditován u úřadu Trusted Introducer). Organizátorem akce byla Evropská agentura pro síťovou a informační bezpečnost (ENISA), jejímž primárním cílem je dosažení vysokého stupně informační a síťové bezpečnosti mezi členskými státy EU.

Na začátku setkání zazněly informace o historii budování CSIRT.CZ a jeho cestě do pozice Národního CSIRT České republiky, o organizační struktuře týmu, ale také sdružení CZ.NIC samotného, o práci Laboratoří CZ.NIC, které se ve svých projektech bezpečností také intenzivně zabývají, Akademii CZ.NIC a jejích vzdělávacích projektech atd. Kolegové z CERT-RO také ocenili informace o pracovní skupině CSIRT.CZ, jejímiž členy jsou zástupci významných provozovatelů sítí, poskytovatelů obsahu, rizikových služeb, bezpečnostních složek České republiky, Českého telekomunikačního úřadu, sdružení CZ.NIC i NIX.CZ a akademického sektoru. Tato pracovní skupina umožňuje setkávání bezpečnostních expertů z uvedených organizací a také vzájemné předávání informací a zkušeností souvisejících s počítačovou bezpečností.

Během setkání jsme zástupce týmu CERT-RO informovali také o nástrojích, které používáme při řešení incidentů, ať už ticketovacího systému OTRS, různých linuxových utilit, rozšíření pro Firefox, či různých nástrojů dostupných on-line. Nejvíce však členy národního CSIRT týmu Rumunska zaujala aplikace, kterou vyvinuly naše laboratoře a jako open source nabídli k používání i dalším registrům. Je to aplikace MDM, o níž jsme již psali zde a jejíž nasazení pomohlo také k lepšímu postavení České republiky v různých statistikách phishingových stránek.

Kolegy z CERT-RO také zaujala prezentace životního cyklu incidentu od jeho vzniku až po jeho vyřešení. Během této přednášky jsme poreferovali o některých zajímavých, či zásadních incidentech, které jsme za poslední rok řešili. Hojně diskutovanou se stala také otázka proaktivního přístupu a úzké spolupráce na úrovni národních CSIRT týmů.

Setkání se zúčastnil také zástupce týmu CESNET-CERTS, který provozuje sdružení CESNET pro dohled nad sítí národního výzkumu a vzdělávání. Oba české bezpečnostní týmy spojuje dlouhodobá a velice úzká spolupráce na poli internetové bezpečnosti v této zemi. Zástupce CESNET-CERTS na tomto setkání prezentoval systém pro efektivní sdílení informací o bezpečnostních událostech. Jeho nasazení je ve spolupráci s CSIRT.CZ plánováno i na národní úrovni.

Dlužno říci, že i náš tým získal zajímavé nové informace. V Rumunsku je existence Národního týmu zakotvena v zákoně a na jeho provozu se podílejí například i kmenoví zaměstnanci bezpečnostních sil. Rumunský národní CERT tým se také momentálně ve spolupráci s vládním sektorem pokouší o spuštění vlastního rozsáhlého IDS systému. Také je zajímavé, že registr rumunské národní domény .RO nezobrazuje a ani nepředává žádné údaje o držitelích domén, pokud jsou tito fyzickými osobami. Z pohledu práce CSIRT týmů je toto jasná nevýhoda při řešení incidentů. A zajímavost na závěr – pokud by někdo z vás toužil pracovat v Národním CSIRT týmu Rumunska, pak vězte, že minimálním požadavkem pro práci v tomto týmu je úspěšné složení certifikace Certified Ethical Hacker (CEH).

Pavel Bašta

Malware podepsán „od Microsoftu“

Malware s digitálním podpisem už není žádná novinka, i když naštěstí pořád rarita – viděli jsme to u ukradených certifikátů (Stuxnet) a certifikátů se slabými faktorizovatelnými klíči. A teď ještě přibyl případ, kde se malware tvářil, jako by byl podepsán přímo od Microsoftu.

Všechny detaily ještě nejsou známé, občas se mlží, ale základní princip je už z některých zveřejněných řetězců certifikátů celkem jasný – Microsoft udělal „sub-CA“ ze všech zákazníků jednoho produktu (enterprise verze Terminal Services), takže mohli podepisovat jakýkoli kód libovolným jménem. Certifikáty Microsoftu umožňující tento podpis jsou již revokovány, původní security advisory je v následujících článcích:

- Microsoft Security Advisory (2718704)

- Unauthorized digital certificates could allow spoofing

- Microsoft certification authority signing certificates added to the Untrusted Certificate Store

CrySys zveřejnil ukázku řetězce certifikátů, na které lze vidět jak celý „trik“ funguje:

- sub-CA „Microsoft Enforced Licensing Registration Authority CA“ se řetězí přes „Microsoft Enforced Licensing Intermediate PCA“, která je podřízená sub-CA pod „Microsoft Root Authority“ CA

- „Microsoft Root Authority“ je kořenová autorita, jejíž certifikát je přítomen v systémovém úložišti certifikátů Windows

- podle OID v X509v3 rozšíření Extended Key Usage je použití certifikátů pro: Code Signing, Key Pack Licenses (szOID_LICENSES), License Server Verification (szOID_LICENSE_SERVER)

- certifikáty neobsahují žádné omezení týkající se jmen (rozšíření Name Constraints není přítomné)

- tudíž jakýkoli podpis kódu ověřený přes tento řetězec se ukáže jako správný

V ukázce od CrySys je certifikát na čtvrté úrovni (Level 4) zřejmě certifikátem sub-CA, který zákazníci mohli použít pro podpis koncového certifikátu kódu. Znamená to, že k němu měli privátní klíč nebo fungovali jako registrační autorita (RA) – tj. nadřazená CA jim poskytovala „orákulum“, které podepsalo cokoliv (z popisu to není úplně jasné, variantě o RA by odpovídala i zkratka LSRA).

Hlavním problémem zde není ani použití PKI per se, ale spíše drobný „detail“, díky němuž se celý řetězec certifikátů řetězil ke kořenovému certifikátu v systémovém úložišti (je označen jako důvěryhodný). Jedna spekulace říká, že si vývojáři nebo architekt chtěli ulehčit život a místo separátní CA použili právě tu existující (ta ale měla vedlejší efekty).

V KB Microsoftu byly ještě zmatené zmínky o MD5 kolizích, ale žádné páry kolizních certifikátů nebyly k dispozici. Až nedávno se na MSDN objevil článek Flame malware collision attack explained, který sice ty kolizní certifikáty taky nemá, ale z analýzy certifikátu je vidět, že certifikát je „podivně“ pozměněn – chybí některé X.509v3 extensions. Při zkoumání se v certifikátu objevilo podivné pole Issuer Unique Identification (v praxi se téměř nepoužívá). To vzniklo právě kolizí a právě bity kolize způsobily, že se tělo pole natáhlo přes zbytek struktury ASN.1 – tudíž se „nepříjemná“ Hydra extension (OID 1.3.6.1.4.1.311.18, označená navíc jako „critical“) stala tělem nějakého řetězce – ten se neparsuje jako extension, tudíž už nepředstavuje problém.

Využití MD5 kolize je založeno na stejném triku, jaký jsem kdysi použil pro demonstraci já nebo mnoho jiných – „binární bordel“ je potřeba nastrkat do nějaké „vaty“ v datové struktuře (tak, že se neovlivní zásadně sémantika změněných dat). Je ale potřeba trochu experimentovat, než člověk trefí správné bity a správné délky. Ty kolizní certifikáty zřejmě podepisovalo „podepisovací orákulum“ někde u Microsoftu; toto orákulum ale nechtělo podepsat libovolný certifikát. Tak si útočníci pomohli s kolizí, při níž jim navíc hrál do karet fakt, že sériové čísla certifikátů a pár dalších polí byly lehce predikovatelné. Musím říct, že je to dost chytrý a elegantní útok. Nečekal jsem, že bych ho po tolika letech viděl „v divočině“.

Stevens a de Weger (autoři proof-of-concept certifikátů s MD5 kolizemi) tvrdí, že MD5 chosen-prefix-collision útok ve Flame je nový oproti jejich útoku. Nicméně myšlenka zůstává stejná – mít možnost zostrojit kolizi pro libovolné IV (odtud chosen-prefix – útočník si může vybrat libovolný kus dat délky násobku bloku před kolizí). Tím pádem novost spočívá pravděpodobně v rychlosti vytvoření kolize nebo menší počet CSR požadavků, než se útočník strefil do očekávaného sériového čísla a času, aby získal pár kolizních certifikátů.

Na závěr trocha odlehčení – CrySys poslal výzvu autorům Duqu, ať zveřejní kód, protože podléhá GPL.

Ondrej Mikle

Jak se promítl včerejší den do podpory IPv6

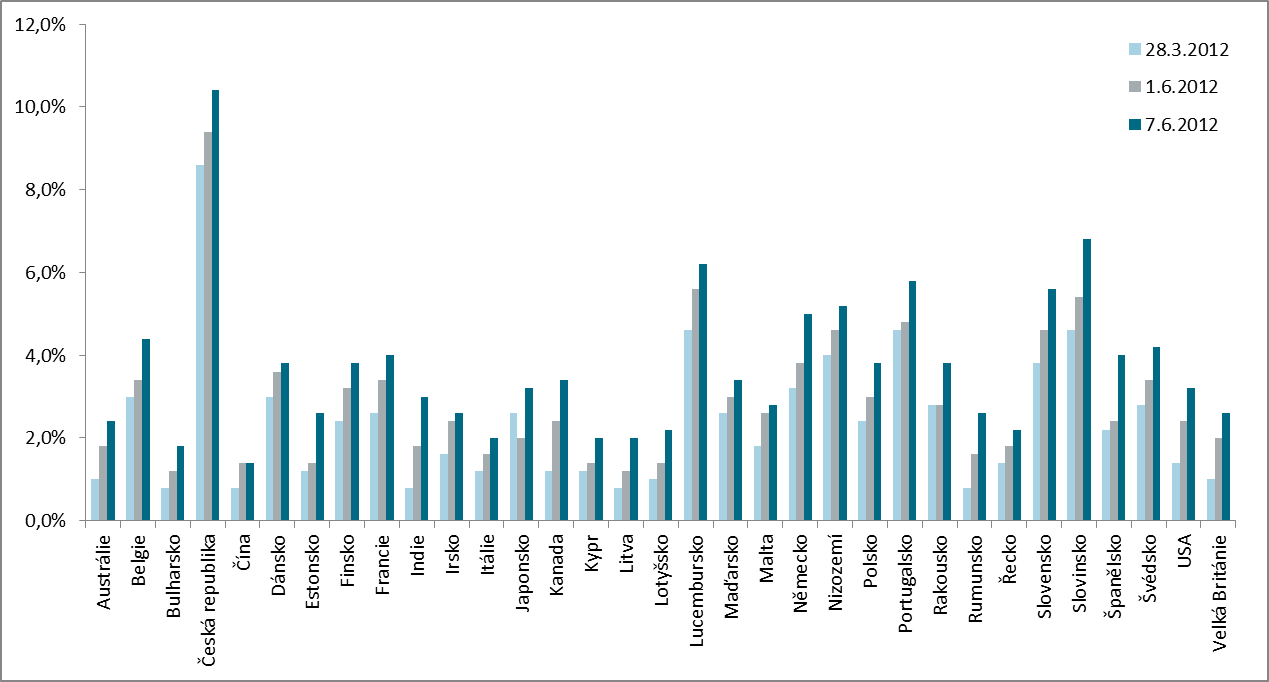

Na konci dubna vydal CZ.NIC tiskovou zprávu zmiňující mimo jiné to, že je Česká republika světovým lídrem v zavádění IPv6, alespoň co se obsahové stránky internetu týče. Vzhledem k tomu, že IPv6 Observatory, z které jsme statistiky přebírali, je aktualizována každý den, zajímalo mě, jak se „Den šestek“ (6. 6. 2012) na těchto statistikách projeví a zda si naše země své prvenství udrží.

Podle zmíněného průzkumu stojí za připomenutí, že 28. března, kdy IPv6 Observatory publikovala první měření, se Česká republika umístila na špičce žebříčku s 8,6 % reprezentujících v absolutních číslech 43 nejvýznamnějších českých webů. V této souvislosti stojí za připomenutí, že na rozdíl od statistik laboratoří CZ.NIC sledující AAAA záznamy v doméně .cz, vychází evropský projekt „IPv6 Observatory“ z 500 nejnavštěvovanějších stránek dle serveru Alexa.com, která mezi české (resp. spíše bychom měli mluvit o „z České republiky navštěvované“) stránky zahrnuje např. LinkedIn, PayPal YouTube, ale i The Pirate Bay či mail.ru, Yandex.ru apod. Na druhou stranu podobné „odchylky“ se vyskytují u všech států a výsledky IPv6 Observatory je tak možné považovat za „spravedlivé“.

Výsledky z prvního červnového dne stále potvrzovaly vedení ČR s 9,4%, druhou příčku pak obhájilo Lucembursko (5,6 %) a třetí v těsném závěsu Slovinsko (5,4 %). Den po World IPv6 Launch Česká republika stále vede a jako první (a jediná ) se přehoupla přes 10 % (přesně 10,4), druhé Slovinsko pak, řečeno sportovní terminologií, ztrácí 18 bodů (stránek), tedy celých 3,8 %. Nárůstu stránek v našich národních barvách pomohla především podpora Seznamu, ale také například Centra Holdings a jejich služeb.

Statistika IPv6 Observatory pak ukázala, že jedinou zemí v průzkumu, ve které se šestkový den neprojevil, je Čína. Vzhledem k tomu, že IPv6 Observatory zobrazuje pouze aktuální výsledky, přichystali jsme pro vás srovnávací graf ukazující nárůst počtu stránek s podporou IPv6. Bez zajímavosti pak není ani to, že zatímco na konci března činil průměr všech zemí zahrnutých v průzkumu 2,4 %, po 6. 6. počet stránek narostl o více než dvě třetiny a nyní hodnota „indexu“ dosahuje 3,7 %.

Podobný nárůst jako IPv6 Observatory zaznamenaly i statistiky našich laboratoří, podle nichž počet webů se šestkou stoupl téměř o tři procenta na 13,28 % a kdy stojíme již jen krůček, respektive 0,42 %, od hranice, kdy bude IPv6 podporovat již polovina DNS serverů. Zde je třeba dodat, že za nárůstem u webů stojí především krok registrátora ACTIVE 24, který včera na konferenci oznámil zpřístupnění IPv6 více než 38 tisíc „svých“ domén, z toho 28 tisíc .cz. Nezanedbatelnou práci ale odvedla i řada drobných hráčů včetně veřejné správy. Z vládních institucí se k World IPv6 Day připojilo Ministerstvo školství, mládeže a tělovýchovy a Úřad průmyslového vlastnictví, k jejichž zapojení pomohl rovněž dopis, který na základě našeho průzkumu rozeslalo všem orgánům bez podpory IPv6 (a tím porušujících Usnesení vlády) Ministerstvo průmyslu a obchodu. Vedle státní správy našel včerejší den ohlas i u samosprávy a ke zpřístupnění obsahu přes šestku se připojilo i 12 českých měst (Aš, Frenštát pod Radhoštěm, Hodonín, Jihlava, Kladno, Milevsko, Neratovice, Přelouč, Valašské Klobouky, Votice, Vsetín a Vyškov), jejichž weby spravuje společnost Webhouse. Zde stojí za zmínku, že z 205 měst s tzv. rozšířenou působností jich šestku podporuje jen 15, což je cca. polovina národního průměru dle našich laboratoří.

Zdá se, že IPv6 Day tak přinesl své ovoce a podpora šestky přestává být, alespoň na straně obsahu, polem neoraným. Doufejme, že podobné nárůsty budeme moci brzo zaznamenat i u providerů či výrobců domácích routerů. Pokud chcete zjistit, zda právě vaše domácí krabička již má podporu nové verze IP protokolu, není niž snazšího, než se podívat do našeho katru!

Jiří Průša

O prázdninách to začne

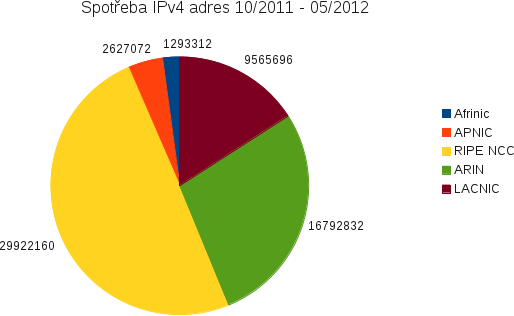

Je to již poměrně dlouho, co jsem naposledy publikoval příspěvek o ubývání IPv4 adres. Dovolte mi tedy krátce okomentovat, co se za ten více než půlrok přihodilo. Asi hlavní zprávou je, že zpřísněná politka RIPE NCC způsobila, že konec IPv4 adres v Evropě byl přeci jen trochu oddálen. To je z pohledu evropana rozhodně dobře, máme tak přeci jen ještě pár chvil na přípravu. Trochu hůře to asi vidí naši asijští kolegové, kteří se už s nedostatkem adres nějaký ten čas potýkají a byli by jistě rádi, kdyby s nimi ostatní regiony sdílely osud. Aktuálně to vypadá, ze RIPE NCC rozdá poslední adresy v polovině prázdnin. Tedy raději připomínám, že ve skutečnosti má ještě něco v zásobě, tedy přímo celý jeden blok /8. Každý člen bude mít z tohoto bloku možnost alokovat dodatečných 1024 adres (/22). Bude si o ně moct požádat, pokud již bude mít IPv6 adresy a prokáže se potřebu. Každopádně to už mnoho firem nespasí.

Od října loňského roku byla největší alokace ze severoamerického regionu. V únoru dostal T-Mobile USA na dnešní poměry gigantické množství 8388608 adres (/9). Druhá největší alokace byla neméně zajímavá. Nešlo totiž o běžné „poslání“ IP adres LIRu, ale IANA vyčlenila 4194304 adres (/10) pro NAT444. Na pomyslném třetím až čtvrtém místě jsou dvě brazilské alokace velikosti 2097152 (/11).

Největší evropské alokace byly pro dva mobilní operátory, a to pro v poslední době hodně sledovaný francouzský Free a pro německý T-Mobile. Obě měly velikost 1048576 (/12)

Mimochodem i dvě největší české alokace od loňského října byly pro mobilní operátory. Šlo o mobilní divizi Telefoniky CR a T-Mobile CR a bylo to 32768 (/17) respektive 16384 (/18) adres. To naznačuje, že Češi rozhodně v současných IPv4 alokacích prim nehrají.

Každopádně nejvíce adres spotřebovali Evropané a to přibližně 30 miliónů, což bylo zhruba tolik, co zbytek světa dohromady. Druhý byl severoamerický ARIN a zajímavé je, že již z hlediska IPv4 vyčerpaný APNIC rozdal více adres než v tomto ohledu blahobytný Afrinic. Graf ilustrující celou situace je k vidění zde; pozn.: u ARINu došlo k přestrukturování bloku 47/8, který původně patřil zkrachovalému Nortelu Canada. Operace v tomto bloku jsem proto pominul).

Jak je vidět, Evropané pokračují v rychlém alokačním tempu. Pojďme se podívat, co jim RIPE NCC může ještě nabídnout. Pod jeho správu spadají tyto /8 bloky: 2, 5, 25, 31, 37, 46, 51, 62, 77, 78, 79, 80, 81, 82, 83, 84, 85, 86, 87, 88, 89, 90, 91, 92, 93, 94, 95, 109, 176, 178, 185, 193, 194, 195, 212, 213, 217. Téměř všechny uvedené bloky jsou zaplněné z více než 99 %. Jedinou výjimku tvoří bloky 176 (96%), 91 (91%), 5 (23%) a 185 (0%). Drtivá většina nově přidělených adres tedy začíná na 5, občas se podaří nějakou kratší alokaci obsloužit z nějakého jiného bloku. Ze čtvrtiny zaplněný blok 5 je tedy prakticky to poslední, co RIPE NCC zbývá. Blok 185 je již poslední přidělený a začne se využívat až bude vše ostatní alokováno, a to za již zmíněných speciálních pravidel. Teď již, myslím, i největší pesimista musí uznat, že situace je vážná a je potřeba něco dělat.

Doufejme, že situaci pomůže svétové spuštění IPv6 plánované na dnešní den, které se uskuteční i u nás v České republice.

Ondřej Filip

Bariéra pro nového operátora

Pokud se alespoň trochu zajímáte o telekomunikace či ekonomiku, rozhodně vás nemohla minout zpráva o tom, že se v České republice chystá velká aukce volných kmitočtů. Organizátor aukce, Český telekomunikační úřad se nechal slyšet, že očekává, vstup nového operátora na český trh. Velká část komentářů se věnuje tomu, zda-li jsou nastavené podmínky skutečně motivující pro nového hráče a jaké obtíže bude muset případný nový operátor překonávat. Dovolte mi, abych i já přidal jeden aspekt, který zatím alespoň dle mého názoru nikde nebyl diskutován.

Předběžné harmonogramy aukce naznačují, že proces skončí nejdříve na přelomu tohoto roku. Od tohoto okamžiku se případný vítěz pustí do budování nové infrastruktury. A také to bude již několik měsíců poté, co v Evropě dojdou IPv4 adresy. Pokud tedy půjde o nového hráče, který se pokusí dobýt nějaký zajímavý tržní podíl stávající mobilní trojce, dá se předpokládat, že jednou z hlavních služeb bude rychlé připojení na Internet, koneckonců aktuální dokumenty k aukci pokrytí vysokorychlostním Internetem přímo vyžadují. Bude tedy lákat především technicky zdatné uživatele, pro které je stálé internetové připojení jejich chytrého telefonu nutností.

Pro sta tisíce takovýchto uživatelů, ale bude muset nový operátor sehnat IPv4 adresy. Trochu se obávám, že v této době by pouze s IPv6 ještě nevystačil. Ale kde je v roce 2013 vzít, když evropský registr RIPE NCC už bude přidělovat maximálně 1024 adres na operátora, což by nestačilo ani pro Carrier Grade NAT. Samozřejmě můžete namítnout, že zcela jistě nepůjde o úplně novou společnost, která doposud o telekomunikacích ani neslyšela. Takže se dá předpokládat, že již nějaké IP adresy dostala, ale i tak si neumím představit, že by registr RIPE NCC přidělil v posledních pár letech komukoliv větší rozsah IP adres aniž by věděl, že je dotyčný skutečně nespotřebuje v aktuálních projektech.

Jinými slovy nový operátor rozhodně nebude mít na růžích ustláno. Krom problémů s dražením kmitočtů, budování infrastruktury a sháněním nových klientů bude muset i řešit, kde vzít IPv4 adresy. Patrně bude muset provést nákup od někoho, kdo je ještě má. A kolik stojí jedna IPv4 adresa nám nedávno naznačila společnost Microsoft, která kupovala IPv4 adresy po 11 USD. Pokud by se protokol IPv6 rozvíjel rychleji, podobné problémy by nový operátor nemusel řešit. S trochou nadsázky se tak dá říct, že podpora nového protokolu IPv6 je vlastně podporou kompetitivnějšího telekomunikačního trhu.

Pokud vás tyto a související otázky zajímají, dovolte, aby vás pozval na konference IPv6 Day, kterou pořádáme 6.6. v Praze v Národní technické knihovně. Registrace je sice již uzavřena, ale nezoufejte, konference bude on-line vysílána po Internetu na http://www.nic.cz/ipv6day/, takže o možnost sledovat zajímavé přednášky a diskuse nepřijdete.

Ondřej Filip

Přes 170 DNS serverů v České republice bylo zneužito při DDOS útoku

Minulý týden přijal náš tým CSIRT.CZ zprávu od Lotyšského týmu CERT.LV o masivním DDOS útoku na cíl v jejich zemi.

Při tomto útoku bylo využito již delší dobu známého útoku DNS Amplification attack. Při tomto útoku posílá útočník DNS dotazy se zdrojovou IP adresou nastavenou na adresu oběti útoku. Záměrně se přitom ptá na informace, které způsobí, že odpověď serveru DNS bude mnohonásobně větší, než původní dotaz. Tyto informace však nebudou posílány na adresu útočníka, ale na IP adresu oběti, která si o ně ve skutečnosti vůbec nežádala. Takto může útočník s relativně pomalým připojením zahltit internetové připojení i daleko rychleji připojené oběti. Tento útok umožňují špatně nakonfigurované rekurzivní DNS servery, které jsou nakonfigurovány jako otevřené. To znamená, že takovýto DNS server poskytuje služby nejen uživatelům ve své síti, ale v podstatě celému světu.

Schéma útoku DNS Amplification attack, zdroj: Lupa.cz.

Zajímavé je, že se na tomto útoku podílelo i více jak 170 DNS serverů z České republiky, a to i přes to, že CZ.NIC již dříve vydal varování před tímto způsobem konfigurace DNS serverů. My jsme samozřejmě informace poskytnuté Lotyšským týmem zpracovali a předali je dál jednotlivým správcům nevhodně nakonfigurovaných DNS, kteří, jak doufáme, již touto dobou dělají příslušná protiopatření. Obáváme se však, že se může jednat jen o špičku ledovce a takto špatně nakonfigurovaných DNS serverů může být v naší zemi daleko více. Z tohoto důvodu plánujeme provést analýzu současného stavu, abychom měli jasnější představu o rozměrech tohoto rizika.

Pavel Bašta

AKTUÁLNÍ UPOZORNĚNÍ – problémy s Datovými schránkami a Datovka

Dnes dopoledne jsme obdrželi několik dotazů uživatelů Datovky na chybové hlášení „Nebylo možné stáhnout informaci o účtu – musí být specifikován typ nebo identifikátor schránky“. Bohužel se nejedná o chybu na straně našeho programu, ale o potvrzenou chybu zavedenou dnes do systému datových schránek.

Na nápravě chyby se podle provozovatele systému ISDS právě pracuje a měla by být odstraněna během několika hodin.

Bedřich Košata

Změny v Pravidlech registrace přinášejí i možnost skrýt další údaje

Dokument s názvem Pravidla registrace čítá celých devět stránek hustého textu, a tak si dovolím ve stručnosti představit novinky, které k 1. červnu vstupují v platnost.

Jednou z drobných změn je úprava přílohy č. 1, podle které může nově být v kontaktu poštovní adresa označena jako neveřejný údaj bez ohledu na to, jakou daný subjekt zastává v centrálním registru pozici (držitel, administrativní kontakt, technický kontakt atp.). Adresa tedy nebude zobrazována ve veřejné části vyhledávání v databázi whois. Jediným údajem, který v centrálním registru nadále zůstane vždy viditelný, je jméno a příjmení. CZ.NIC touto změnou vychází vstříc zákonným požadavkům na ochranu osobních údajů.

Zákon na ochranu osobních údajů se však týká pouze fyzických osob – údaje o právnických osobách lze nalézt v řadě veřejně dostupných registrů. Také v případě centrálního registru budou možností skrýt poštovní adresu disponovat pouze fyzické osoby. Aby nedocházelo k nežádoucímu „zosobňování“ právnických osob účelovým označováním za fyzické osoby, vyplňováním názvu a obchodních firem do položky jméno a příjmení nebo vynecháním některých údajů, bude moci údaje skrýt pouze subjekt, který prošel tzv. validací – jednoduchým a bezplatným ověřením údajů prostřednictvím služby mojeID. U takto ověřených subjektů bude CZ.NIC bezpečně vědět, že kontakt patří fyzické osobě, která bude mít možnost skrýt svou poštovní adresu a navíc získá možnost využívat výhod validovaného kontaktu služby mojeID na řadě serverů, kam se lze s využitím mojeID přihlásit.

K ochraně osobních údajů zbývá dodat, že ačkoliv subjekt díky validaci službou mojeID získá větší míru kontroly nad tím, komu a v jakém rozsahu své údaje sděluje, CZ.NIC je může v souladu se zákonem na základě požadavku předat orgánům činným v trestném řízení. O kontaktní údaje může požádat i veřejnost, ovšem pouze pokud řádně vyplní zvláštní žádost, ve které doloží účel, kvůli kterému o informace žádá. Pro každý kontakt bude nutné podat samostatnou žádost, a to výhradně písemně s ověřeným podpisem žadatele. Tento relativně složitý administrativní postup má zabránit zneužívání tohoto institutu. CZ.NIC si rovněž vyhrazuje právo poskytnutí údajů odmítnout, pokud dojde k závěru, že požadavek je neoprávněný a žadatel pro svou žádost neprokázal legitimní důvod.

Další změna ve správě údajů v registru se týká zahraničních držitelů. Od června budou subjekty, jejichž bydliště, sídlo či kontaktní adresa se nacházejí mimo území EU/EHP, povinny na výzvu sdružení CZ.NIC nebo příslušného státního orgánu (soudu, správního orgánu, ale také rozhodce či rozhodčího soudu) poskytnout doručovací adresu na území EU/EHP nebo označit svého zástupce s doručovací adresou na tomto území. Problémy s doručováním do exotických lokalit jsou dlouhodobou záležitostí a přispívají ke značnému ztížení možnosti domáhat se svých práv u soudu. Pro větší účinnost komunikace a usnadnění doručování písemností na poštovní adresu uvedenou v registru byla zrovnoprávněna komunikace prostřednictvím elektronické pošty, tedy na e-mail uvedený v registru. Výzva ke sdělení bude odeslána elektronicky a pokud CZ.NIC neobdrží požadované informace ve lhůtě 15 dnů od jejího odeslání, bude mít právo danou doménu zrušit. Je důležité dodat, že tento postup bude uplatněn zejména v případě, kdy se CZ.NIC buď dozví důvěryhodné informace o nesprávnosti údajů v registrům nebo bude o sdělení údajů požádán příslušným orgánem.

Zuzana Průchová Durajová

Další klíčky změnily svá zabarvení

Důležitá oznámení o zavedení DNSSEC jsme naposledy zaznamenali na konci loňského roku a týkaly se Vodafone a Telefónicy. Od té doby se žádná společnost nepochlubila, až do dnešního dne.

Centrum Holdings dnes vydalo tiskovou zprávu, ve které oznamuje zavedení DNSSEC pro řadu svých webů, mezi které patří například Centrum.cz, Aktuálně.cz nebo katalog firem Najisto.cz. Rádi se přiznáme k tomu, že tuto implementaci vítáme hned dvakrát. Typicky přesně tyto služby si totiž DNSSEC zaslouží.

Druhým přírůstkem do rodiny je potom portál Bezpečnostní informační služby – www.bis.cz. Podepsána je tedy internetová stránka dalšího významného státního úřadu a co víc, první z bezpečnostních sborů v naší zemi.

A pár čísel na závěr, pro připomenutí. DNSSEC je tu s námi od podzimu 2008, kdy se Česká republika stala teprve pátou zemí na světě, která tuto bezpečnostní technologii do své národní domény zavedla. V současnosti chrání DNSSEC 343 478 domén .cz, což je více než třetina z celkového počtu zaregistrovaných domén s českou národní koncovkou. Tato čísla nás udržují nad ostatními registry domén využívající DNSSEC.

Vilém Sládek

Chcete pomoci s vybudováním unikátní databáze? Přineste nám svůj router!

World IPv6 Launch se blíží a my se na něj stejně jako řada dalších těšíme a připravujeme. A v rámci těchto příprav jsme se rozhodli, že vás taky zatáhneme do hry. O co jde?

V druhé půlce naší konference IPv6 Day máme v programu prezentaci kolegy Petra Černohouze (Stav podpory IPv6 na domácích routerech), který má ve svých rukou řadu projektů věnovaných IPv6. Jedním takovým je i IPv6 Laboratoř, z níž se pro potřeby konference vyklubal nejen workshop, ale také prezentace o routerech a dalších zařízeních dostupných v České republice, která více či méně umí nebo neumí IPv6. S jejich získáním nám pomohli v CZC.cz, takže dostatečný základ hardwaru pro testování máme – ASUS, Linksys, CISCO, D-LINKy, Netgeary, Zyxel. Přesto jsme si řekli, že by zde routerů mohlo být k dispozici více, a tak přicházíme s jednou neodolatelnou nabídkou, výzvou.

Doneste nám 4. června svoje síťová zařízení pro přístup k internetu a nechte si je na místě, tedy v IPv6 Laboratoři, otestovat! Během 3/4 hodiny se nejen že dozvíte, jestli jste si koupili ten správný hardware, ale zároveň (v našich očích především) pomůžete s vybudováním zajímavé databáze dostupných zařízení podporující IPv6. Samozřejmostí je i volná vstupenka na IPv6 Day.

Jestli jsme se vás touto naší nabídkou dotkli na správném místě, napište kolegovi Petru Černohouzovi na mailovou adresu petr.cernohouz@nic.cz; ve zprávě uveďte, jaké zařízení byste přinesli a kdy byste chtěli k nám do IPv6 Laboratoře 4. června přijít. Pokud již bude vaše zařízení v naší testovací sadě, přijďte se dozvědět o jeho schopnostech přímo na IPv6 Day. Budeme se těšit.

Vilém Sládek