Venkovní teploty oproti včerejšku sice poněkud opadly, ale i tak bude myslím ideální, když dnešní díl seriálu o budování privátního sálu pojedná o jeho chlazení. Technologie v datovém centru totiž generují obrovské množství tepla (my kalkulujeme s řádově desítkami kW) a bez chlazení, nebo při jeho výpadku, se za pár minut „upečou“. Myšleno v nadsázce. Dnes to již neplatí. Všechny technologie, které budeme v privátním sále provozovat, se při případném přehřátí automaticky vypnou, což dává vlastně stejný výsledek, protože služby na nich přestanou běžet. A výpadky chlazení se opravdu stávají. Ve své praxi jsem je zažil několikrát a často přispěly i ke změně provozovatele datového centra.

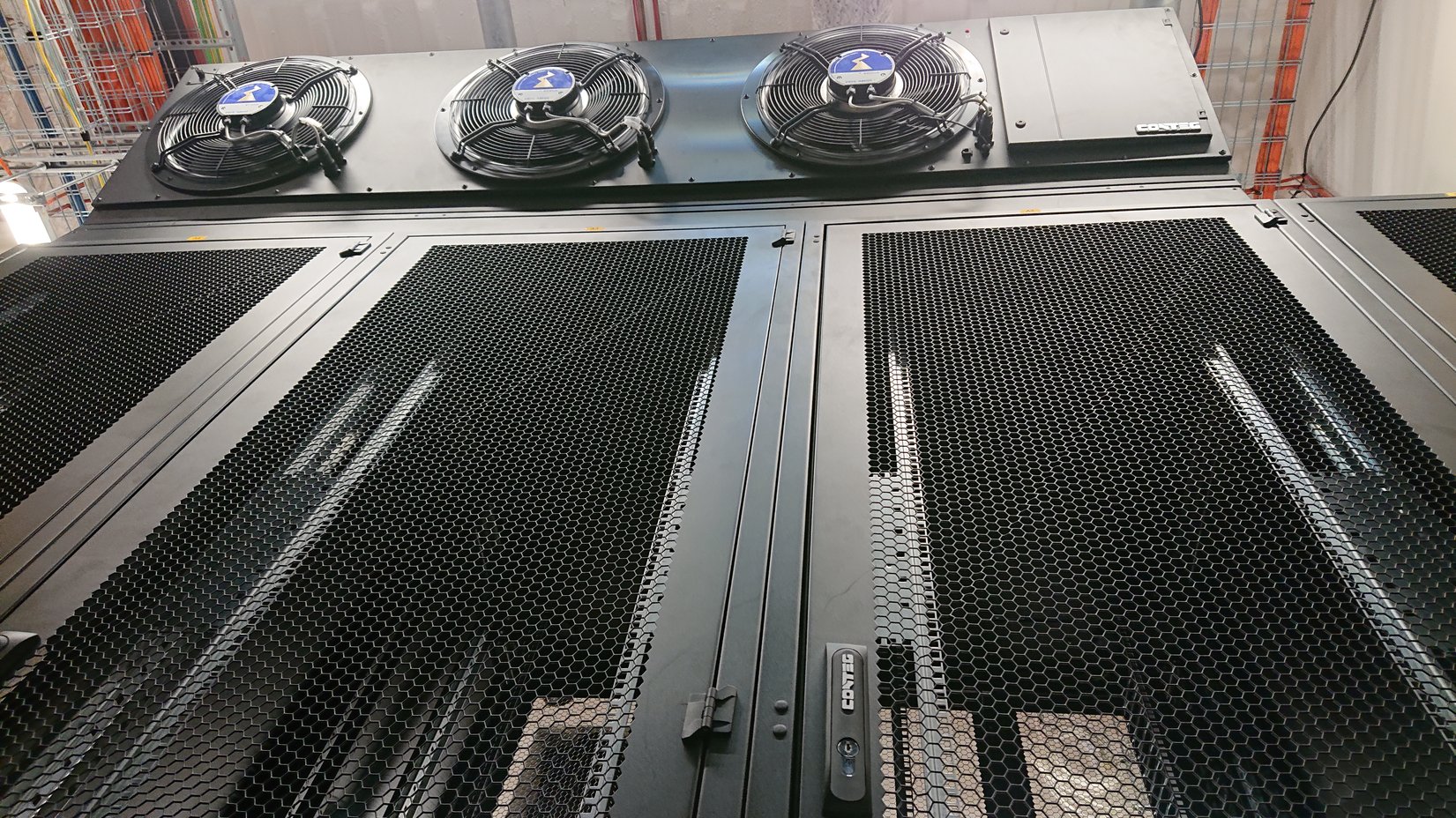

V předcházejícím dílu seriálu jsem psal, že máme v privátním sále opravdu hodně vysoko do stropu a že budeme používat racky o výšce 52U, mimo jiné i kvůli získání dalšího prostoru pro naše technologie. Dnes dodávám, že v privátním sále nebudeme mít, oproti tomu stávajícímu zdvojenou podlahu. Nebude ani zapotřebí, protože pro chlazení budeme používat jiný způsob distribuce chlazeného vzduchu. Oproti často používané distribuci pod zmíněnou zdvojenou podlahou je v našem případě použito chlazení tzv. „záplavou“. V obou případech je chladný vzduch nasáván ze studené uličky přes perforované dveře a vyfukován, potom co projde chlazenými technologiemi, do uličky teplé. Dodávky studeného vzduchu na našem privátním sále zajistíme pomocí dvou nadrackových (máme opravdu vysoko do stropu, kolikrát jsem to již psal? :)) klimatizačních jednotek Conteg CoolTop (každá se třemi EC ventilátory), čtyř vnějších jednotek a dvou zvlhčovačů. Obě vnitřní jednotky budou v provozu maximálně na 50 % výkonu v redundanci 1+1. Při výpadku jedné jednotky najede druhá jednotka do plného výkonu. Distribuce chladného vzduchu z CoolTop jednotky je velice plynulá, protože máme přístup vzduchu rovnoměrný před všechny racky ve studené uličce. CoolTop má jednu obrovskou výhodu, tj. velký průtok vzduchu. Jen pro zajímavost, pokud bude v chodu jeden CoolTop na 100 %, tak se vzduch ve studené uličce vymění za šest sekund, což je výkonově více než dostatečné. Ohledně sání teplého vzduchu do jednotky je z pohledu projektu uděláno maximum, tj. nad i kolem jednotek je dostatek volného prostoru pro sání vzduchu z druhé poloviny sálu. Z fyzikálního principu, kdy teplo stoupá vzhůru ke stropu, si jednotky Cool Top tento teplý vzduch dokáží nasát i z protilehlé teplé uličky. Níže je několik fotek z minulého čtvrtka, kdy byla instalace chlazení ještě v běhu a například ještě nebyla zakrytována studená ulička. Na poslední z fotek jsou výše zmíněné zvlhčovače, které doplňují vlhkost v sále, aby neklesla pod 20 %. Pak se totiž zvyšuje riziko statického výboje.

Nadrackovým jednotkám jsme zpočátku poněkud nedůvěřovali. Provozovateli DC Tower nám ale byla názorně předvedena již delší dobu provozovaná podobná instalace, přičemž po exkurzi přímo u výrobce jsme přišli i o poslední pochybnosti. Měli jsme obavy zejména z možného průsaku kondenzátu, který se při chlazení vytváří, ale tomuto je zabráněno instalací kovové vany s aktivním odčerpáním a záložním pasivním odtokem.

Jinak stav instalace privátního sálu má menší zpoždění. Ke dnešku máme osazeny vstupní dveře, plní se klimatizace, dnes se instaluje slaboproud (kamery, zabezpečovačka, čidla, atp.), PDU v racích jsou již pod napětím, probíhá instalace potřebných propojů, finalizuje se instalace vzduchotechniky a zvlhčovačů. Dnes dojde k zakrytování studené uličky, kontrole funkčnosti čidel a k drobným stavebním dodělávkám. Čekáme dále na dokončení systému hašení, kde schází instalace přetlakových klapek a trysek s tlumiči. Do konce týdne by ale mělo dojít i k úklidu a připraví se provozní testy. Během příštího týdne by mělo dojít k zaškolení našich lidí, možná i k předání sálu k našemu využívání. Pak začneme s instalací našich technologií.

Díky za článek. Je dobré se podívat, jak to dělají jiní.

Jako minule, dovolím si mít všetečné dotazy: CoolTop2 nebo CoolTop 3? Liší se max. průtokem vzduchu. A verze s přímým výparem anebo vodní? Tipuju DX, protože v dokumentaci píšou, že DX verze může fungovat s jednou nebo dvěma venkovními jednotkami, což pak dál uvádíte. Tímhle ovšem přijdete o freecooling, což je škoda. U mě dělá režie chlazení při freecoolingu (do cca 19 °C venkovní teploty) okolo 9 %, zatímco u strojního chlazení přes 30 %, roční průměr 19 %.

Jinak teda ten průtok vzduchu není až tak impozantní – píšou 7700 resp. 11000 m3/h. 11000 m3/h = 3 m3/s = 3 kW přenesených na 1 °C teplotního rozdílu (velmi přibližně). Pokud budete mít v serverovně i něco jiného než velmi hustě osazené blade servery (běžné 1U servery, switche, disková pole, atd.), budete rádi, pokud dosáhnete delta-T 7-8 °C. Takže s jednou takovouto jednotkou uchladíte 21-24 kW výkonu. Pak už si studená ulička začne přisávat vzduch z teplé strany netěsnostma. Až tak to nevadí, v této situaci jde snížit setpoint pro teplotu studené uličky a tím trochu zvýšit delta-T. Problém je, že tohle se dost špatně detekuje – rozdílové tlakoměry jsou pro tento účel málo přesné. A taky to přisávání je dost nerovnoměrné, takže pak někde zjistíte, že vám do jednoho serveru jde o 5 °C víc než do jiného.

Nevím kolik přesně jsou ty „desítky kW“, se kterými počítáte, ale možná máte přecejen malý průtok vzduchu.

Jde o variantu CoolTop3 v provedení s přímým výparem, tj. DX. Klimatizace má dva okruhy, tj. ke dvěma klimatizacím jsou čtyři venkovní jednotky. Konstantní přetlak ve studené uličce je řízený automatikou, která v případě poklesu automaticky zvyšuje otáčky ventilátorů. Dodržení nastavené teploty je hlídáno čidly napojenými na klimatizační jednotky.

Ohledně případného freecoolingu bylo technické řešení dáno v neposlední řadě celkovým cenovým modelem. Pro očekávaný příkon IT do 45 kW by byly náklady na jeho dobudování neúměrné celkové investici a modelovým úsporám z provozu freecoolingu.

Vhodnost a dostatečnost výkonu chlazení (tedy i objem vháněného vzduchu) nedefinujeme my, ale specializovaní projektanti, kteří v posledních letech pracovali na většině datových center, která u v ČR vznikla. Navíc nespoléháme pouze na teorii, ale provádíme i praktické zátěžové testy, s jehož výsledky Vás v příštích týdnech rádi seznámíme.

Pokud by ani to vysvětlení nepostačovalo, můžeme nabídnout osobní návštěvu datacentra a diskusi s odborníky na tuto problematiku. Dle erudovanosti Vašeho dotazu si myslím, že by to byla optimální varianta.

Tak do nového datacentra se pozvat nechám, pokud by tato možnost byla, díky za nabídku. Nejlépe až to bude dobudované a aspoň trochu osazené a budou aspoň trochu zkušenosti s provozem. Třeba ještě někdy budeme stavět další serverovnu, a zkušenosti s úplně jinými koncepcemi se můžou vždycky hodit.

Já jsem zjistil, že sice typický projektant má daleko větší přehled o tom, co kde na trhu existuje, a co se kde dá s výhodou zkombinovat, ale zase praktické zkušenosti z konkrétního provozu se k němu až tak dobře nedostávají. Je to způsobeno i tím, že většina správců datacenter jede v režimu „nějak nám to tady postavili, víceméně to funguje, náklady na provoz neřeším a mám důležitější věci na práci“. Takže nějak moc bych se odborným projektantem nezaklínal :-)

Ještě pokud si můžu dovolit dávat knížecí rady (sorry, nemůžu si pomoct :-), tak jeden z problémů tady těch high-availability systémů nejen u chlazení je detekovat, jestli vlastně došlo k poruše. Taky se může stát, že jednotlivé komponenty nenahlásí žádnou poruchu, ale fungovat dobře nebudou. V jedné menší serverovně jsem například měl DX jednotku, která přestala chladit, nic nepoznala, ale ventilátory dál poctivě odebíraly horký vzduch z teplé strany a foukaly ho do studené strany. Což je samozřejmě horší, než kdyby spořádaně vypadla úplně.

Ale tak třeba to váš zamýšlený řídící systém sleduje skutečně nezávisle a počítá i s těmito různými polovýpadky. Každopádně se nenechte uvrtat do nějakého uzavřeného řídícího systému – po roce provozu si začnete říkat „teď by se mi hodilo, aby v této konkrétní situaci to chlazení začalo dělat tohle“, ale samozřejmě doprogramovat to tam snadno nepůjde (neptejte se, jak to vím :-).

Omlouvám se za opožděnou reakci. To pozvání do DC berte jako fakt, ale až později letos, až budeme mít vše trošku zaběhlé, zatím jsme před migrací a je před námi moře práce. Jinak je určitě pravda, že projektanti bývají někdy trošku mimo realitu, ale v našem případě je mezi nimi a námi ještě provozovatel DC, který, na rozdíl od nás, potřebné zkušenosti z praxe má. A mimochodem, sál prošel zátěžovými testy a uchladí se bez problému i v mezních situacích. Jakmile budeme mít z testů k dispozici protokol, určitě se s výsledky pochlubíme. Díky moc za Váš zájem a vlastně i za rady! :)